AIチップ

脳に学ぶ

2020.10.21

数学から生まれたコンピュータ

太古の昔、人は指を折って数え、歩数を数えて測量しました。しかし、人は大きな数を認知できません。そこで四大文明期には計算機が登場して、人の認知能力を拡張しました。

古代ギリシャ時代以降は、数学の内部世界が研究対象となり、数学は道具から思考に進化しました。15世紀のルネサンスで記号代数が発明され、実世界では表現できないn次元の空間も考察できるようになりました。こうして数学は、物理的制約を受けない普遍的な視座を獲得したのです。

やがて17世紀になると微積分が考案され、無限の世界を探究できるようになりました。極限や連続性の概念を厳密に省察する結果、主観的な直感を超越した抽象的な記号体系が生まれました。そして20世紀に入ると、「数学をする自らの思考について数学をする」試みまで現れます。

このように、数学は、身体を離れて脳に宿り、物理的直感や主観的感覚などといった曖昧なものを完全に脱ぎ捨て、ついに脳から溢れ出しました。それがコンピュータです。

当初の電子式コンピュータでは、真空管がよく故障しました。そこで、気体ではなく固体の中で電子を制御するトランジスタが1948年に発明されました。

また、コンピュータの機能は回路の配線で決まるいわゆる「布線論理」でしたが、ここには2つの課題がありました。処理できるプログラムの最大規模が予め用意したハードウェアの規模で制約されてしまう「規模制約問題」と、システムが大規模になると接続数が膨大になる「大規模システムの接続問題」です。

そこで、フォン・ノイマンは、処理対象の「データ」と、データの移動および演算を指示する「命令」をメモリに記憶しておき、プロセッサがこの命令を解釈して演算処理を逐次行う「プログラム内蔵方式(フォン・ノイマン方式)」を発明しました。複数の演算器を用意してそれらを物理的に結線するのではなく、一つの演算器に毎サイクル違う命令を実行させることで規模制約問題の解消を狙った画期的な方式転換だったのです。

一方、ジャック・キルビーは、1958年に集積回路(IC)を発明しました。フォトリソグラフィを用いて、一枚のチップに素子と配線を集積することで、「大規模システムの接続問題」を見事に解決したのです。やがてシリコンがICに最適な材料であることが見出されました。

こうして単純化・極小化された演算資源をシリコンチップに集積化・並列化することで、コンピュータの性能は飛躍的に向上し、高性能になったコンピュータはさらに大規模な集積回路の設計を可能にしました。

このように、フォン・ノイマン方式と集積回路とシリコンが出会い、コンピュータとチップは手を携えて指数関数的な進化を遂げたのです。

仕事をするとエネルギーを消費します。電子回路の仕事量、つまり性能は、給電と放熱の制約を受けます。エネルギー、あるいはエネルギーの流速である電力の効率を高めることが、チップの性能を高めます。

チップの電力効率は過去20年間に3桁改善され、脳の1/100程度にまで向上しています。また、チップの集積度も脳の神経細胞の数の1/100程度です。これまでの勢いがあれば、10年後には脳に追いつくはずです。

しかし、フォン・ノイマン方式では、大量のデータと命令がプロセッサとメモリの間を行き来するので、そこが細長い首のようにボトルネックになっています(フォン・ノイマン・ボトルネック)。また、シリコンチップは、今世紀に入りデバイスの寸法が100nmより小さくなった頃から量子効果が現れ、リーク電流を抑えられません。半世紀前に誕生したコンピュータとチップの成長の限界が見えてきたのです。

しかし限界を迎える前に、コンピュータは自ら学習する能力を備えました。機械学習です。そして脳の神経回路網を模したAIチップが誕生したのです。

脳に学ぶAIチップ

神経回路網(Neural Network)を設計するための要素技術は20世紀のうちに開発されていたものの、NNが表現できる空間は広大すぎて、4層以上の深層神経回路網(Deep Neural Network)を学習させることは困難でした。

しかし21世紀に入り、オートエンコーダの深層化に成功したり、学習に必要なコンピュータの性能が十分に高まったことで、深層学習(Deep Learning)が従来の情報処理に比べて圧倒的に高い処理性能を発揮するようになり、急速に実用化されました。

回路網の構成やアーキテクチャの研究も進みました。画像認識では近くの信号だけを結合させるCNN(Convolutional Neural Network)が成功しました。また、音声や自然言語処理のような時系列データを扱う認識処理では、再帰型のRNN(Recurrent Neural Network)やLSTM(Long Short Term Memory)が研究されました。最近は、重要な部分に注目するAttentionが導入され、Self-Attention機構を用いることでRNNの再帰構造を用いないTransformerアーキテクチャが注目されています。

いずれも、私たちの脳をヒントにして研究が進んでいます。中でも重要だと考えられているのが、神経回路網の刈り込み(プルーニング)です。

私たちの脳のシナプスは、生まれたときは50兆個ほどしかありませんが、生後1歳までに1000兆個に増えます。しかしその後は、学習によってシナプスは減少します。信号が通り強化されたシナプスは残りますが、信号が来ない不要なシナプスは刈り込まれて消えて行くのです。10歳頃までにはシナプスは半減し、その後は変化が少なくなります。

つまり、幼児期初期までに完全結合に近い神経回路網が形成されますが、学習するにつれて、不必要な配線が除去され必要な配線だけが残されるのです。こうして、無駄のない機能的な脳回路が形成されます。

子供の脳は学習を行うために大きく、大人の脳は推論を効率よく行うために刈り込まれているのです。小さく生んで、大きく育てて、社会で学ばせるという戦略は、脳が発達した哺乳類の生存戦略なのでしょう。

脳とシリコン脳

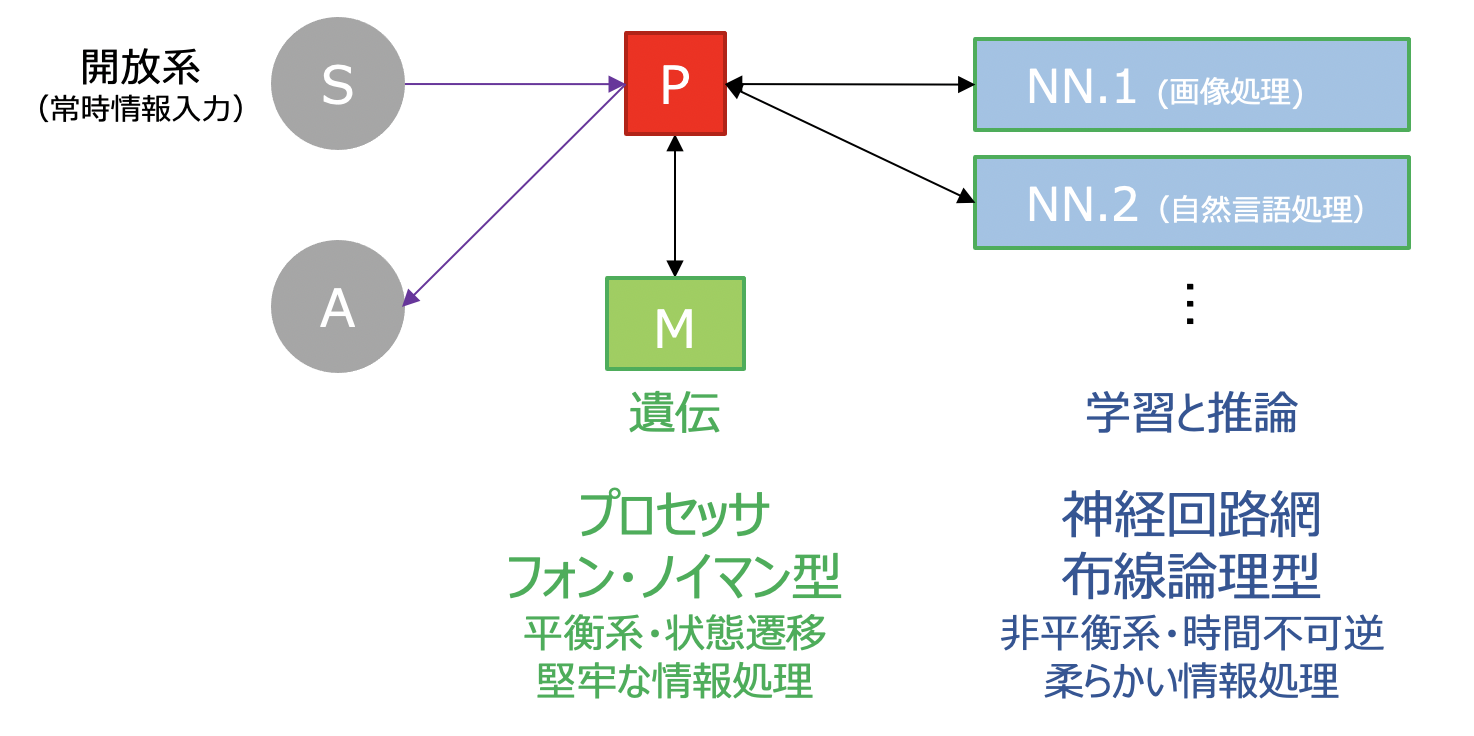

脳とシリコン脳に関するここまでの話を整理すると、 数学から生まれたフォン・ノイマン型のコンピュータが、予めプログラムされた状態遷移に基づき堅牢な情報処理を行います。それはちょうど、遺伝で機能が備わった視床・偏桃体・小脳に似ています。

一方、脳に学んだ布線論理型の神経回路網が、開放系で学習を続けながらプルーニングを行い、時間不可逆な柔らかい情報処理をエネルギー効率良く行います。それはちょうど、社会で学ぶ大脳皮質のようです。

このようにシリコン脳は、人の脳を参考にして描くことができます(下図)。では、シリコン脳は人の脳と同じような構造になるのでしょうか?

プロセッサが視床・偏桃体・小脳の役割を担い、神経回路網が大脳皮質の役割を担う。

(S: センサー、A:アクチュエータ、P:プロセッサ、M:メモリ、NN:神経回路網)

「すごいダイナミックレンジだ!」

1981年にそう叫んだのは、研究室の先輩の合原一幸さん(現在東大名誉教授)でした。神経軸索の活動電位の発生と伝播を記述した非線形微分方程式のHodgkin-Huxley方程式を計算機で解析したところ、神経軸索の抵抗値が大きく変化したのです。

同様の特性を持った人工物を造り出すことは容易ではありません。脳とシリコン脳は、鳥と飛行機のように、違う原理と構造になるかもしれません。

神経回路網は、配線の接続が機能を決める「布線論理」です。配線をプログラムできるFPGA(Field Programmable Gate Array)に私は期待を寄せています。